一、 One-shot Learning

解决的问题

使用少量的样本进行快速的学习

解决的方法

- Transfer Learning

- Meta Learning

- One-shot Learning with Memory-Augumented Neural Networks

- Optimization as a Model for Few Shot Learning

- Model-Agnostic Meta Learning (MAML)

二、Model Agnostic Meta Learning

- Intuition

- 在任务之间的相关性,(Interal representations)

- 任务之间迁移

- 类似于迁移学习

- Meta Learning

- 参数对微小的变化敏感

- 极大的优化了在任何问题上的Loss function

2.1 定义

- 模型$f(\theta):(x→a)$, 输入$x$, 输出$a$

- 任务$T =\{L(x_1, a_1, . . . , x_H, a_H), q(x_1), q(x_{t+1}|x_t, a_t),H\}$ ,其中$L$是trajectory的Loss,其将产生一个针对于特定任务的反馈 ,$H$是episode length,$q(x_1)$是初始observation 分布,$q(x_{t+1}|x_t,a_t)$是状态转移。

- 对于监督学习任务来说,$H=1$

- $P(T)$是模型期望的任务分布,元学习场景中,希望模型能够适应的任务分布。

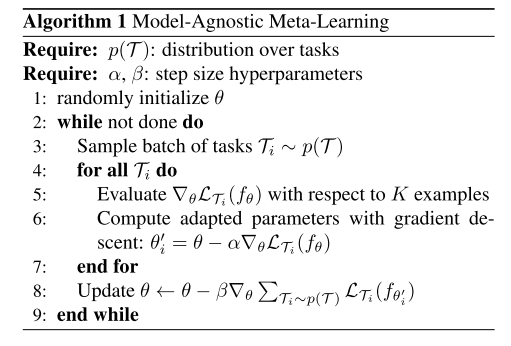

- 对于K-shot Learning 来说,在元学习过程中,从$P(T)$中采样一个任务$T_i$,模型用$K$个样本进行训练,然后从$T_i$对应的Loss中进行feedback,之后在从$T_i$上采样的新样本上进行测试。

2.2 方法

模型$f_\theta$,当去适应新的任务$T_i$时,模型参数从$\theta$更新为$\theta’_i$:

这里的参数$\alpha$可以当成变量也可以当成超参数

目标函数(Meta objective)

Meta optimization

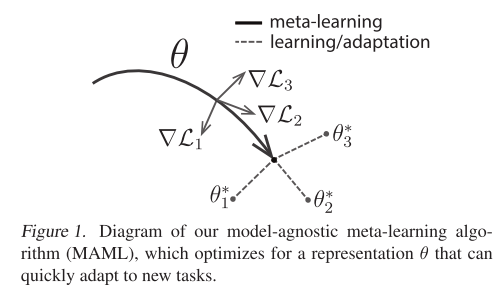

直观表示适应过程